AI-Betrug erklärt: Wie KI-gestützter Betrug funktioniert und wie Unternehmen ihn aufdecken

Wichtige Erkenntnisse

- AI-Betrugsfälle stiegen im Jahr 2025 um 1.210 % und übertrafen damit bei weitem das Wachstum von 195 % bei herkömmlichen Betrugsfällen. Die prognostizierten Verluste könnten bis 2027 40 Milliarden US-Dollar erreichen.

- Sieben verschiedene Arten von KI-Betrug zielen derzeit auf Unternehmen ab, wobei Deepfake-Videos, KI-Stimmklonen und KI-gestützte Business Email Compromise (BEC) das höchste Risiko für Unternehmen darstellen.

- Herkömmliche Abwehrmaßnahmen versagen. Durch KI generiertes phishing die grammatikalischen Fehler, generischen Nachrichten und manuellen Einschränkungen, auf die sich herkömmliche E-Mail-Filter und Sensibilisierungsschulungen stützten, um Betrug aufzudecken.

- Die Verhaltenserkennung schließt diese Lücke. Netzwerk-Erkennung und -Reaktion (NDR) sowie Identitätsbedrohungserkennung und -reaktion (ITDR) erkennen anomale Netzwerk-, Identitäts- und Datenflussmuster, die von inhaltsbasierten Sicherheitstools übersehen werden.

- Eine mehrstufige Verifizierung ist nun obligatorisch. Finanzkontrollen mit doppelter Genehmigung, Out-of-Band-Verifizierung und vorab geteilte Code-Phrasen reduzieren das Risiko, wenn ein einzelner Kommunikationskanal synthetisch repliziert werden kann.

KI-gestützter Betrug ist nicht mehr nur ein theoretisches Risiko. Allein im Jahr 2024 verzeichnete das FBI IC3 Verluste in Höhe von 16,6 Milliarden US-Dollar durch Cyberkriminalität – ein Anstieg von 33 % gegenüber dem Vorjahr –, wobei KI-gestütztes Social Engineering einen wachsenden Anteil dieser Vorfälle ausmachte. Ein einziger Deepfake-Videoanruf kostete das Ingenieurbüro Arup 25,6 Millionen US-Dollar. KI-generiertes phishing erzielen mittlerweile eine mehr als viermal höhere Klickrate als ihre von Menschen verfassten Pendants. Und laut dem Global Cybersecurity Outlook 2026 des Weltwirtschaftsforums waren 73 % der Unternehmen im Jahr 2025 direkt von Cyberbetrug betroffen.

Dieser Leitfaden erläutert, wie KI-Betrug funktioniert, welche Arten von Betrug Sicherheitsteams am häufigsten begegnen, welche Verluste zuletzt zu verzeichnen waren und – ganz entscheidend – wie Unternehmen KI-gestützten Betrug erkennen und darauf reagieren können, wenn herkömmliche Abwehrmaßnahmen versagen.

Was sind KI-Betrügereien?

KI-Betrug sind Betrugsmaschen, bei denen künstliche Intelligenz – darunter große Sprachmodelle, Stimmklonen, Deepfake-Videos und autonome KI-Agenten – eingesetzt wird, um Opfer in einem bisher unmöglichen Ausmaß und mit einer bisher unmöglichen Raffinesse zu täuschen. Dabei werden die menschlichen Grenzen überwunden, die herkömmliche Social-Engineering-Methoden erkennbar und langsam machten.

Während herkömmliche Betrugsmaschen von den Fähigkeiten, Sprachkenntnissen und der Zeit des Angreifers abhingen, entfallen diese Einschränkungen bei KI-Betrug vollständig. Ein Angreifer muss die Sprache des Opfers nicht mehr fließend beherrschen. Er muss keine individuellen Nachrichten mehr manuell verfassen. Und er muss nicht mehr stundenlang Vorbereitungen für einen einzigen Versuch treffen.

Der Internationale KI-Sicherheitsbericht 2026 hat ergeben, dass die KI-Tools, die diese Betrugsmaschen ermöglichen, kostenlos sind, keine technischen Fachkenntnisse erfordern und anonym genutzt werden können. Diese Kombination – keine Kosten, keine Fachkenntnisse, keine Rechenschaftspflicht – erklärt, warum KI-Betrug schneller zunimmt als jede andere Bedrohungskategorie.

Über die direkten finanziellen Verluste hinaus verursachen KI-Betrügereien einen „Wahrheitsverfallseffekt“. Da Deepfake-Videos, geklonte Stimmen und KI-generierte Texte nicht mehr von authentischen Kommunikationen zu unterscheiden sind, verlieren Unternehmen die Fähigkeit, digitalen Interaktionen ohne Weiteres zu vertrauen. Jeder Videoanruf, jede Sprachnachricht und jede E-Mail wird verdächtig.

Wie sich KI-Betrug von herkömmlichem Betrug unterscheidet

Der grundlegende Wandel besteht in Geschwindigkeit und Qualität in großem Maßstab. Traditionelle Betrugsmaschen basierten auf menschlicher Arbeit und wiesen erkennbare Mängel auf – Rechtschreibfehler, umständliche Formulierungen, allgemeine Begrüßungen. KI-Betrugsmaschen erzielen Ergebnisse in menschlicher Qualität mit maschineller Geschwindigkeit.

Betrachten Sie phishing Ausgangspunkt. Laut einer Studie von IBM X-Force kann KI innerhalb von fünf Minuten eine überzeugende phishing erstellen. Ein menschlicher Forscher benötigt für die manuelle Erstellung einer E-Mail gleicher Qualität 16 Stunden. Das entspricht einer 192-fachen Geschwindigkeitssteigerung bei gleicher oder besserer Qualität – das heißt, ein einzelner Angreifer kann nun an einem Tag das produzieren, wofür zuvor ein Team von Spezialisten monatelang arbeiten musste.

Die Auswirkungen verstärken sich in großem Maßstab. KI erreicht nicht nur menschliche Qualität. Sie personalisiert jede Nachricht anhand von Daten, die aus LinkedIn-Profilen, Unternehmensunterlagen und sozialen Medien gewonnen werden. Eine Studie von Brightside AI aus dem Jahr 2024 ergab, dass KI-generierte phishing eine Klickrate von 54 % erreichten, verglichen mit 12 % bei herkömmlichem phishing ein 4,5-facher Effektivitätsmultiplikator.

Wie KI-Betrug funktioniert

Für Verteidiger ist es unerlässlich, die Werkzeuge der Angreifer zu verstehen. KI-gestützte Betrugsmethoden kombinieren mehrere Technologien zu einer koordinierten Angriffskette, wobei in jeder Phase unterschiedliche KI-Fähigkeiten zum Einsatz kommen.

Das Klonen von Stimmen ist einer der am leichtesten zugänglichen Angriffsvektoren. Untersuchungen von McAfee haben ergeben, dass bereits drei Sekunden Audioaufzeichnung ausreichen, um einen Stimmklon mit einer Genauigkeit von 85 % zu erstellen. Wie Fortune im Dezember 2025 berichtete, hat das Klonen von Stimmen die „Unterscheidbarkeitsgrenze” überschritten – das bedeutet, dass menschliche Zuhörer geklonte Stimmen nicht mehr zuverlässig von authentischen Stimmen unterscheiden können.

Die Erstellung von Deepfake-Videos hat sich von offensichtlichen Fälschungen zu interaktiven Avataren in Echtzeit weiterentwickelt. Neue Modelle gewährleisten zeitliche Konsistenz ohne Flackern, Verzerrungen oder Uncanny-Valley-Artefakte, auf die frühere Erkennungsmethoden angewiesen waren. Der Fall Arup hat gezeigt, dass Deepfake-Video-Teilnehmer erfahrene Fachleute in Live-Gesprächen täuschen können.

LLM-gestütztes phishing nutzt große Sprachmodelle, um hyper-personalisierte E-Mails zu generieren, die sich auf spezifische organisatorische Details, aktuelle Transaktionen und individuelle Kommunikationsstile beziehen. Diese KI-gestützten phishing weisen keine der verräterischen Anzeichen auf, auf deren Erkennung herkömmliche E-Mail-Filter trainiert wurden.

Autonome Betrugsagenten stellen die neueste Entwicklung dar. Laut einer Studie von Group-IB aus dem Jahr 2026 kombinieren KI-gestützte Betrugscallcenter nun synthetische Stimmen, LLM-gesteuertes Coaching und KI-gestützte Inbound-Responder, um vollständig automatisierte Betrugsoperationen in großem Maßstab durchzuführen.

Die KI-Betrugs-Toolchain

AI-Betrugstoolchains kombinieren nun Stimmklonen, Deepfake-Videos und Dark LLMs zu standardisierten Diensten, die weniger kosten als ein Streaming-Abonnement.

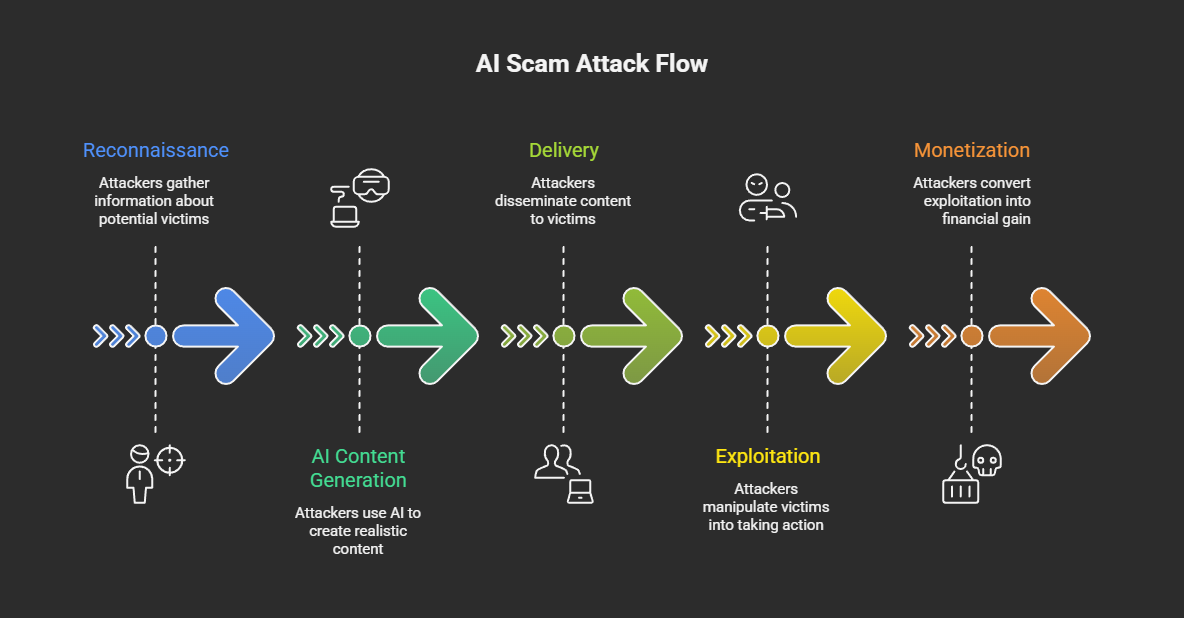

Ein typischer KI-Betrugsangriff verläuft in fünf Phasen:

- Aufklärung – Angreifer sammeln öffentliche Daten (aus sozialen Medien, Unternehmensunterlagen, Konferenzaufzeichnungen), um Zielprofile zu erstellen und Sprach- und Videobeispiele zu sammeln.

- KI-Inhaltsgenerierung – Mithilfe von Dark LLMs, Sprachklon-Diensten und Deepfake-Generatoren erstellen Angreifer personalisierte phishing , synthetische Sprachnachrichten oder Deepfake-Videos.

- Lieferung – KI-generierte Inhalte erreichen ihre Ziele per E-Mail, Telefonanruf, Videokonferenzplattformen, Messaging-Apps oder sozialen Medien.

- Ausbeutung – Die Opfer reagieren auf die betrügerische Kommunikation, indem sie Geld überweisen, Zugangsdaten weitergeben, Zugriffsrechte gewähren oder schädliche Anwendungen installieren.

- Monetarisierung – Gestohlene Gelder werden über Kryptowährungsbörsen, Geldkuriere oder betrügerische Investitionsplattformen verschoben.

Die Wirtschaftlichkeit treibt das Wachstum voran. Group-IB dokumentierte synthetische Identitäts-Kits, die für etwa 5 US-Dollar erhältlich sind, und Dark-LLM-Abonnements, die zwischen 30 und 200 US-Dollar pro Monat kosten. Bis Ende 2025 gab es schätzungsweise acht Millionen Deepfakes im Internet – gegenüber etwa 500.000 im Jahr 2023 –, was einem jährlichen Wachstum von etwa 900 % entspricht.

Die Eintrittsbarrieren sind praktisch verschwunden. Jeder, der über einen Internetzugang und ein kleines Budget verfügt, kann nun KI-gestützte Social-Engineering-Kampagnen starten, für die noch vor fünf Jahren Ressourcen auf staatlicher Ebene erforderlich gewesen wären.

Arten von KI-Betrug

KI-Betrug umfasst mittlerweile sieben verschiedene Angriffsvektoren, wobei Deepfake-Videos, Stimmklonen und KI-gestützte BEC das größte Risiko für Unternehmen darstellen. Die folgende Taxonomie umfasst sowohl Varianten, die sich an Verbraucher als auch an Unternehmen richten.

Tabelle: Taxonomie der Arten von KI-Betrug mit Risikobewertung für Unternehmen. Bildunterschrift: Häufige Arten von KI-Betrug, ihre Angriffsmethoden, primäre Ziele, Risikostufen für Unternehmen und empfohlene Erkennungsansätze.

Laut ScamWatch HQ haben Deepfake-Video-Betrügereien im Jahr 2025 um 700 % zugenommen. Gen Threat Labs hat allein im vierten Quartal 2025 159.378 einzigartige Deepfake-Betrugsfälle entdeckt. Zu den Varianten für Unternehmen gehören die Imitation von Führungskräften in Videoanrufen (wie im Fall Arup), Deepfake-Anzeigen, in denen sich Finanzmanager ausgeben, und Deepfake-Bewerber, die von nordkoreanischen Agenten eingesetzt werden.

AI-Stimmklonen und Vishing-Angriffe überschreiten mittlerweile 1.000 AI-Betrugsanrufe pro Tag bei großen Einzelhändlern. Über die Ausrichtung auf Verbraucher hinaus verwenden Angreifer geklonte Stimmen von Führungskräften, um betrügerische Überweisungen zu autorisieren und sich in Social-Engineering-Kampagnen als Regierungsbeamte auszugeben.

KI-generiertes phishing phishing haben einen Wendepunkt erreicht. Analysen von KnowBe4 und SlashNext zeigen, dass 82,6 % der phishing mittlerweile KI-generierte Inhalte enthalten, während Hoxhunt berichtet, dass 40 % der BEC-E-Mails in erster Linie KI-generiert sind. Der Unterschied zwischen diesen Zahlen spiegelt wahrscheinlich den Unterschied zwischen „jeglicher KI-Unterstützung” und „vollständig KI-generierten” Methoden wider.

Laut FBI IC3 verursachten KI-gestützte Business Email Compromise-Angriffe im Jahr 2024 bei 21.442 Vorfällen Verluste in Höhe von 2,77 Milliarden US-Dollar. KI verwandelt BEC von reinen E-Mail-Angriffen in multimodale Kampagnen, die E-Mail, Sprache und Video kombinieren, um äußerst überzeugende Identitätsfälschungen zu schaffen.

Betrugsfälle im Zusammenhang mit KI-Investitionen und Kryptowährungen nehmen rapide zu. Im Rahmen der Operation „Truman Show“ von Check Point wurden 90 KI-generierte „Experten“ in kontrollierten Messaging-Gruppen eingesetzt, die die Opfer dazu veranlassten, mobile Apps mit servergesteuerten Handelsdaten zu installieren. Chainalysis meldete für das Jahr 2025 Verluste in Höhe von 14 Milliarden US-Dollar durch Krypto-Betrug, wobei sich KI-gestützte Betrugsfälle als 4,5-mal profitabler erwiesen als herkömmliche Betrugsmaschen.

AI-Romantikbetrug nutzt große Sprachmodelle, um emotional intelligente Gespräche in großem Umfang zu führen. Der „2026 Future of Fraud Forecast” von Experian identifiziert KI-gestützte, emotional intelligente Bots als eine der größten neuen Bedrohungen, da sie in der Lage sind, Dutzende von „Beziehungen” gleichzeitig zu unterhalten und dabei ihren Tonfall und ihre Persönlichkeit an jedes Zielobjekt anzupassen.

Auf Unternehmen ausgerichtete KI-Betrugsmaschen

Unternehmen sind mit einer Reihe von KI-Betrugsarten konfrontiert, die Vertrauensbeziehungen und Autorisierungsabläufe ausnutzen.

Die Identitätsfälschung von Führungskräften mittels Deepfakes zielt auf Transaktionen mit dem höchsten Wert ab. Der Fall Arup, bei dem ein Finanzmitarbeiter durch einen vollständig gefälschten Videoanruf getäuscht wurde, an dem auch der scheinbare CFO teilnahm, und der zu 15 separaten Transaktionen im Gesamtwert von 25,6 Millionen Dollar führte, ist nach wie vor der bekannteste Fall. Er wurde nur durch eine manuelle Überprüfung durch die Unternehmenszentrale entdeckt.

Deepfake-Bewerber stellen eine neue und anhaltende Bedrohung dar. Das FBI, das DOJ und die CISA haben Fälle von IT-Mitarbeitern aus Nordkorea dokumentiert, von denen 136 oder mehr US-Unternehmen betroffen waren. Die Mitarbeiter verdienten mehr als 300.000 US-Dollar pro Jahr und eskalierten zu Datenerpressung. Gartner prognostiziert, dass bis 2028 jedes vierte Bewerberprofil gefälscht sein könnte.

KI-gestütztes phishing großem Maßstab zielt auf ganze Branchen ab. Brightside AI dokumentierte eine Kampagne, die sich an 800 Wirtschaftsprüfungsgesellschaften richtete und KI-generierte E-Mails mit spezifischen Angaben zur staatlichen Registrierung enthielt. Die Klickrate lag bei 27 % und damit weit über dem Branchendurchschnitt für phishing .

AI-Betrug in Zahlen: Statistiken für 2024–2026

AI-gestützte Betrugsfälle stiegen im Jahr 2025 um 1.210 % an, wobei die prognostizierten Verluste bis 2027 40 Milliarden US-Dollar erreichen dürften, da AI-Tools Social Engineering in großem Maßstab demokratisieren.

Tabelle: Statistiken zu KI-Betrug und Deepfake-Betrug, 2024–2026. Bildunterschrift: Wichtige Kennzahlen zu finanziellen Verlusten, Angriffsvolumen und Verbreitung von KI-gestütztem Betrug aus zuverlässigen Quellen.

Hinweis zum Datenumfang: Die Zahl des FBI IC3 (16,6 Milliarden US-Dollar) bezieht sich nur auf Beschwerden, die den US-Strafverfolgungsbehörden gemeldet wurden, und sollte als Mindestwert betrachtet werden. Die Zahl der GASA (442 Milliarden US-Dollar) ist eine globale Schätzung, die auch nicht gemeldete Verluste umfasst und auf einer Umfrage unter 46.000 Erwachsenen in 42 Ländern basiert. Beide Zahlen sind hinsichtlich ihrer jeweiligen Methodik und ihres Umfangs korrekt.

Diese Zahlen entsprechen direkt den Cybersicherheitskennzahlen des Unternehmens, die CISOs für die Berichterstattung an den Vorstand und die Rechtfertigung von Investitionen benötigen.

KI-Betrug in Unternehmen: Fallstudien aus der Praxis

Die Verluste durch KI-Betrug in Unternehmen reichen von 25,6 Millionen Dollar durch einen einzelnen Deepfake-Betrug bis hin zu Milliardenverlusten durch BEC-Betrug pro Jahr. Cyberbetrug hat mittlerweile ransomware größte Sorge von CEOs abgelöst.

Der WEF Global Cybersecurity Outlook 2026 deckte eine auffällige Diskrepanz bei den Prioritäten auf: Cyberbetrug überholte ransomware Hauptsorge der CEOs im Jahr 2026, doch für die meisten CISOs ransomware das Hauptthema. 72 % der Führungskräfte nannten KI-Betrug als eine der größten operativen Herausforderungen, wobei 87 % von zunehmenden KI-bezogenen Schwachstellen berichteten.

Arup Deepfake-Videoanruf – 25,6 Millionen Dollar

Im Januar 2024 wurde ein Finanzmitarbeiter im Hongkonger Büro von Arup zu einem Videoanruf mit dem vermeintlichen CFO des Unternehmens und mehreren Kollegen eingeladen. Alle Teilnehmer waren Deepfakes, die aus öffentlich zugänglichen Konferenzaufnahmen generiert worden waren. Der Mitarbeiter autorisierte 15 separate Überweisungen in Höhe von insgesamt 25,6 Millionen US-Dollar (200 Millionen HKD). Der Betrug wurde erst entdeckt, als der Mitarbeiter später über einen separaten Kanal eine Überprüfung bei der Unternehmenszentrale vornahm.

Erkenntnis: Bei der finanziellen Autorisierung kann man sich nicht allein auf Videoanrufe verlassen. Unternehmen müssen für Transaktionen mit hohem Wert eine Out-of-Band-Verifizierung und doppelte Genehmigungskontrollen implementieren.

DPRK Deepfake-Bewerber

Das FBI hat Betrugsmaschen nordkoreanischer IT-Fachkräfte dokumentiert, von denen 136 oder mehr US-Unternehmen betroffen sind. Die Betrüger nutzen Deepfake-Technologie, um Video-Vorstellungsgespräche zu bestehen, und verdienen dann über 300.000 US-Dollar pro Jahr, während sie die Einnahmen in Nordkoreas Waffenprogramme fließen lassen. Einige sind zu Datenerpressung übergegangen und drohen mit der Veröffentlichung gestohlener geschützter Informationen. Gartner geht davon aus, dass bis 2028 jedes vierte Bewerberprofil gefälscht sein könnte.

Check Point „Truman Show“ Anlagebetrug

Im Januar 2026 deckten Forscher von Check Point eine Operation auf, bei der 90 KI-generierte „Experten“ eingesetzt wurden, um kontrollierte Messaging-Gruppen zu bevölkern. Die Opfer wurden angewiesen, eine mobile Anwendung zu installieren, die in offiziellen App-Stores erhältlich war und servergesteuerte Handelsdaten mit gefälschten Renditen anzeigte. Die Angreifer schufen eine vollständig synthetische Realität, um den Betrug aufrechtzuerhalten.

Branchenspezifische Targeting-Muster

Verschiedene Branchen sind mit unterschiedlichen Arten von KI-Betrug konfrontiert. Finanzdienstleister sehen sich vor allem mit BEC, Überweisungsbetrug und Betrug in Kontaktzentren konfrontiert. Ein US-amerikanischer Gesundheitsdienstleister berichtete, dass mehr als 50 % des eingehenden Datenverkehrs aus Bot-gesteuerten Angriffen bestand. Große Einzelhändler geben an, täglich mehr als 1.000 KI-generierte Betrugsanrufe zu erhalten. Technologie- und IT-Personalvermittlungsagenturen sind am stärksten von Deepfake-Bewerbern betroffen.

Laut Cyble waren 30 % der schwerwiegenden Fälle von Unternehmensidentitätsdiebstahl im Jahr 2025 mit Deepfakes verbunden – was bestätigt, dass KI-generierte synthetische Medien sich von einer Neuheit zu einem zentralen Bestandteil von Betrugsdelikten gegen Unternehmen entwickelt haben. Eine effektive Planung für die Reaktion auf Vorfälle muss nun diese KI-gestützten Angriffsvektoren berücksichtigen.

Erkennen und Verhindern von KI-Betrug

Die Abwehr von KI-Betrug in Unternehmen erfordert eine mehrschichtige Erkennung, die Verhaltensanalysen, Identitätsüberwachung und Netzwerkanalysen umfasst, da KI-generierte Inhalte zunehmend inhaltsbasierte Sicherheitskontrollen umgehen.

Hier ist ein geordneter Rahmen für die Abwehr von KI-Betrug in Unternehmen:

- Setzen Sie Verhaltensanalysen und NDR ein – Network Detection and Response identifiziert anomale Netzwerkmuster, die mit KI-Betrugsinfrastrukturen in Verbindung stehen, darunter Command-and-Control-Kommunikation, Sprachsynthese-Datenverkehr und ungewöhnliche Datenflüsse.

- Implementieren Sie die Erkennung von Identitätsbedrohungen – Die Erkennung und Reaktion auf Identitätsbedrohungen (ITDR) markiert anomale Authentifizierungsmuster, ungewöhnliche Zugriffsanfragen und Verhaltensabweichungen, die auf kompromittierte oder synthetische Identitäten hinweisen.

- Verlangen Sie mehrstufige Verifizierungskontrollen – Verlangen Sie eine doppelte Genehmigung für Finanztransaktionen über separate Kommunikationskanäle. Legen Sie vorab vereinbarte Verifizierungsphrasen für Notfallkommunikationen fest. Verifizieren Sie alle hochwertigen Anfragen über Out-of-Band-Kanäle.

- Verbessern Sie die Schulungen zum Sicherheitsbewusstsein – Verlegen Sie den Schwerpunkt der Schulungen vom Aufspüren grammatikalischer Fehler hin zum Erkennen psychologischer Manipulation, Dringlichkeitsdarstellung und ungewöhnlicher Anfragekontexte. Die Untersuchungen von IBM zum Thema Social Engineering im Zusammenhang mit KI bestätigen, dass herkömmliche Schulungen zum Aufspüren von Tippfehlern mittlerweile wirkungslos sind.

- Setzen Sie KI-gestützte E-Mail-Sicherheit ein – Nutzen Sie ML-basierte E-Mail-Filter, die Verhaltensmuster analysieren und nicht nur Inhaltssignaturen. Microsoft Cyber Signals Ausgabe 9 beschreibt, wie Verhaltensanalysen das erkennen, was signaturbasierte Tools übersehen.

- Implementieren Multi-Faktor-Authentifizierung überall ein – Stellen Sie sicher, dass die MFA alle Zugriffspunkte abdeckt, wobei phishing Methoden (FIDO2, Hardware-Token) für Konten mit hohen Berechtigungen Vorrang haben sollten.

- Akzeptieren Sie die Grenzen der Deepfake-Erkennung – Die inhaltsbasierte Deepfake-Erkennung wird mit zunehmender Qualität der Generierung immer unzuverlässiger. Gartner prognostiziert, dass bis 2026 30 % der Unternehmen eigenständige Lösungen zur Identitätsprüfung als unzuverlässig ansehen werden. Die Erkennung von Verhaltensbedrohungen bietet eine wichtige ergänzende Ebene.

MITRE ATT&CK für KI-Betrugsbedrohungen

Die Zuordnung von KI-Betrugstechniken zum MITRE ATT&CK hilft GRC-Teams und Sicherheitsarchitekten dabei, KI-Betrugsrisiken in bestehende Bedrohungsmodelle zu integrieren.

Tabelle: MITRE ATT&CK , die für KI-gestützte Betrugsmaschen relevant sind. Bildunterschrift: Zuordnung von KI-Betrugsmethoden zu MITRE ATT&CK mit Hinweisen zur Erkennung.

Regulatorisches Umfeld für KI-Betrug

Das regulatorische Umfeld für KI-Betrug verschärft sich rapide.

- NIST Cyber AI Profile (IR 8596) – Dieser am 16. Dezember 2025 veröffentlichte Entwurf eines Rahmenwerks befasst sich mit drei Bereichen, die direkt für die Abwehr von KI-Betrug relevant sind: Sicherung von KI-Systemkomponenten, Durchführung von KI-gestützter Cyberabwehr und Vereitelung von KI-gestützten Cyberangriffen (NIST IR 8596).

- Durchsetzungsmaßnahmen der FTC – Die FTC hat mehrere Maßnahmen gegen KI-gestützte Betrugsmaschen ergriffen, darunter Fälle mit gefälschten KI-Investmenttools, durch die Verbraucher um mindestens 25 Millionen Dollar betrogen wurden.

- Verordnung des Weißen Hauses zur KI – Die Verordnung vom Dezember 2025 zur „Sicherung eines nationalen politischen Rahmens für künstliche Intelligenz” legt einen bundesweiten Regulierungsrahmen für KI fest und schafft eine Task Force für KI-Rechtsstreitigkeiten.

- Staatliche KI-Gesetze – Am 1. Januar 2026 traten mehrere staatliche Gesetze in Kraft, darunter Vorschriften in Kalifornien und Texas. Colorado S.B. 24-205, das sich mit den Verpflichtungen im Bereich der KI-Governance befasst, tritt im Juni 2026 in Kraft.

Moderne Ansätze zur Abwehr von KI-Betrug

Die Branche konvergiert zu einem Verteidigungsparadigma, das KI einsetzt, um KI zu bekämpfen. Zu den aktuellen Ansätzen gehören Verhaltensanalysen, Identitätsbedrohungserkennung, Netzwerkverkehrsanalyse, KI-gestützte E-Mail-Sicherheit, Deepfake-Erkennungswerkzeuge und weiterentwickelte Plattformen für Sicherheitsschulungen.

Mehrere Trends prägen die Landschaft. Eine einheitliche Erkennung über Netzwerk-, cloud, Identitäts- und SaaS-Oberflächen ersetzt isolierte Tools, die nur eine einzige Angriffsfläche überwachen. Interaktive Deepfakes in Echtzeit stellen Herausforderungen dar, die mit statischer Inhaltsanalyse nicht gelöst werden können. Und agentische KI – autonome KI-Systeme, die im Namen der Benutzer handeln – führt neue Betrugsvektoren ein, bei denen Maschinen andere Maschinen manipulieren.

Investitionssignale bestätigen die Dringlichkeit. Adaptive Security hat insgesamt 146,5 Millionen US-Dollar an Finanzmitteln aufgebracht, darunter die erste Investition von OpenAI im Bereich Cybersicherheit, die sich speziell auf den Schutz vor Social Engineering mittels KI konzentriert. 94 % der vom WEF befragten Führungskräfte erwarten, dass KI im Jahr 2026 die bedeutendste Kraft im Bereich Cybersicherheit sein wird.

Wichtige Termine für Verteidiger: Frist für die Grundsatzerklärung der FTC am 11. März 2026; erwarteter Jahresbericht 2025 des FBI IC3 im April 2026; Umsetzung des Colorado S.B. 24-205 im Juni 2026.

Wie Vectra AI der Erkennung von KI-Betrug Vectra AI

Der Ansatz Vectra AI konzentriert sich auf die Erkennung von Netzwerk- und Identitätsverhalten, das darauf hindeutet, dass KI-gestützte Betrugskampagnen über die anfängliche Social-Engineering-Phase hinaus fortgeschritten sind. Durch die Überwachung auf anomale Command-and-Control-Kommunikationen, ungewöhnliche Authentifizierungsmuster und Datenexfiltrationsflüsse im Zusammenhang mit KI-Betrugsinfrastrukturen Attack Signal Intelligence die Lücke, die entsteht, wenn inhaltsbasierte Abwehrmaßnahmen und menschliches Urteilsvermögen zunehmend gegen KI-generierte Angriffe versagen. Dies entspricht der „Assume-Compromise”-Philosophie: Es ist zuverlässiger, Angreifer zu finden, die sich bereits innerhalb der Umgebung befinden, als jeden KI-gestützten Social-Engineering-Versuch am Perimeter zu verhindern.

Schlussfolgerung

AI-Betrugsfälle stellen die am schnellsten wachsende Betrugskategorie im Bereich Cybersicherheit dar, angetrieben durch kostenlose, leicht zugängliche und anonyme Tools. Die Daten sprechen eine eindeutige Sprache: 1.210 % Wachstum bei AI-gestütztem Betrug, prognostizierte Verluste in Höhe von 40 Milliarden US-Dollar bis 2027 und 73 % der Unternehmen bereits betroffen.

Unternehmen, die sich erfolgreich gegen diese Bedrohung verteidigen, weisen gemeinsame Merkmale auf. Sie setzen mehrschichtige Erkennungsmechanismen für Netzwerke, Identitäten und E-Mails ein, anstatt sich auf eine einzige Kontrollmaßnahme zu verlassen. Sie implementieren Finanz-Workflows mit doppelter Genehmigung, die keinem einzelnen Kommunikationskanal vertrauen. Sie schulen ihre Teams darin, psychologische Manipulationsmuster zu erkennen, anstatt sich auf grammatikalische Fehler zu konzentrieren. Und sie akzeptieren die Realität, dass sie von einer Kompromittierung ausgehen müssen: KI-generiertes Social Engineering wird manchmal erfolgreich sein, sodass eine schnelle Erkennung und Reaktion ebenso wichtig ist wie Prävention.

Für Sicherheitsteams, die ihre Bereitschaft bewerten, ist das Rahmenwerk klar. Ordnen Sie Ihre Anfälligkeit für KI-Betrug den oben dokumentierten MITRE ATT&CK zu. Bewerten Sie, ob Ihre aktuellen Erkennungsmaßnahmen Anomalien im Netzwerkverhalten, Identitätsbedrohungen und E-Mail-basierte Angriffe abdecken. Und stellen Sie sicher, dass Ihre Vorgehensweisen bei Vorfällen Deepfakes, Stimmklonen und KI-generierte phishing berücksichtigen.

Entdecken Sie, wie die PlattformVectra AI Netzwerk- und Identitätsverhalten erkennt, das auf KI-gestützte Betrugskampagnen hindeutet – und dabei das aufspürt, was inhaltsbasierte Abwehrmaßnahmen übersehen.

Grundlagen der Cybersicherheit

Häufig gestellte Fragen

Wie kann man erkennen, ob ein Video ein Deepfake ist?

Achten Sie auf subtile Unstimmigkeiten bei der Beleuchtung, der Lippensynchronisation und den Mikroausdrücken im Gesicht – insbesondere im Bereich der Augen, des Haaransatzes und des Kiefers. Auch Fehler bei der audiovisuellen Synchronisation und unnatürliche Blinkmuster können auf synthetische Inhalte hinweisen. Neuere Deepfake-Modelle eliminieren diese visuellen Artefakte jedoch zunehmend, sodass die inhaltsbasierte Erkennung als eigenständiger Ansatz unzuverlässig wird. Unternehmensverteidiger sollten sich nicht ausschließlich auf die visuelle Überprüfung verlassen. Verhaltenssignale sind zuverlässigere Indikatoren: ungewöhnliche Anfragen, Dringlichkeitsdarstellungen, Auslöser für Finanztransaktionen und Kommunikation über unerwartete Kanäle. Im Zweifelsfall sollten Sie die Identität aller Teilnehmer eines Videoanrufs über einen separaten, vorab festgelegten Kommunikationskanal überprüfen, bevor Sie eine Aktion genehmigen. Gartner prognostiziert, dass 30 % der Unternehmen bis 2026 die eigenständige Identitätsprüfung als unzuverlässig einstufen werden.

Was sollten Sie tun, wenn Sie Opfer eines KI-Betrugs werden?

Privatpersonen sollten sofort den Kontakt abbrechen, die betrogene Partei über einen bereits hinterlegten, verifizierten Kanal kontaktieren, den Vorfall der FTC unter reportfraud.ftc.gov und dem FBI IC3 unter ic3.gov melden und ihr Finanzinstitut benachrichtigen, damit dieses alle betroffenen Konten sperrt. Für Organisationen sollte die Reaktion Ihrem Incident-Response-Plan entsprechen: Isolieren Sie betroffene Systeme, sichern Sie alle forensischen Beweise (E-Mails, Anrufaufzeichnungen, Chat-Protokolle, Netzwerkprotokolle), überprüfen Sie den Umfang der Kompromittierung über Identitäts- und Finanzsysteme hinweg und benachrichtigen Sie die relevanten Stakeholder gemäß Ihrem Playbook. Dokumentieren Sie die spezifischen verwendeten KI-Techniken (Deepfake-Video, geklonte Stimme, KI-generierte E-Mail), da diese Informationen den Strafverfolgungsbehörden helfen, Muster zu verfolgen und Fälle aufzubauen.

Kann KI Sie am Telefon betrügen?

Ja. Laut einer Studie von McAfee benötigt die KI-Stimmklonung nur drei Sekunden Audio, um eine 85-prozentige Stimmübereinstimmung zu erzielen. Angreifer beziehen Audio aus Social-Media-Videos, Voicemail-Ansagen, Konferenzaufzeichnungen und sogar kurzen Telefongesprächen. Große Einzelhändler berichten mittlerweile, dass sie täglich mehr als 1.000 KI-generierte Betrugsanrufe erhalten. Laut einer Analyse von Fortune hat das Klonen von Stimmen die „Unterscheidbarkeitsgrenze“ überschritten, was bedeutet, dass menschliche Zuhörer geklonte Stimmen nicht mehr zuverlässig von authentischen Stimmen unterscheiden können. Unternehmen sollten Verifizierungsverfahren einrichten, die sich niemals allein auf die Stimmerkennung verlassen. Verwenden Sie vorab vereinbarte Code-Phrasen, rufen Sie über unabhängig verifizierte Nummern zurück und verlangen Sie eine doppelte Genehmigung für alle telefonisch autorisierten Finanztransaktionen.

Was ist Schweineschlachten?

Das „Schweineschlachten“ (auch bekannt als „Sha Zhu Pan“) ist ein langfristiger Investitionsbetrug, bei dem Angreifer über Wochen oder Monate hinweg eine Beziehung zum Opfer aufbauen – „das Schwein mästen“ –, bevor sie es auf betrügerische Investitionsplattformen leiten. KI hat diesen Betrug durch automatisiertes Persönlichkeitsmanagement industrialisiert. Die Operation „Truman Show“ von Check Point setzte 90 KI-generierte „Experten“ in kontrollierten Messaging-Gruppen ein und schuf so ein vollständig synthetisches soziales Umfeld um jedes Opfer herum. Die Opfer installieren mobile Apps mit servergesteuerten Handelsdaten, die gefälschte Renditen anzeigen. Sobald die Opfer erhebliche Geldbeträge eingezahlt haben, wird die Plattform unzugänglich. Daten von Chainalysis zeigen, dass die Verluste durch Krypto-Betrug im Jahr 2025 14 Milliarden US-Dollar erreichten, wobei Pig Butchering-Betrügereien einen erheblichen Anteil daran hatten.

Wie funktionieren KI-Romantikbetrügereien?

AI-Romantikbetrug nutzt große Sprachmodelle, um überzeugende, emotional intelligente Gespräche in großem Umfang auf Dating-Plattformen und in Messaging-Apps zu führen. Im Gegensatz zu menschlich betriebenem Romantikbetrug, bei dem pro Opfer eine Person benötigt wird, ermöglicht es die KI einem einzigen Betreiber, Dutzende von Beziehungen gleichzeitig zu unterhalten, jede mit einem personalisierten Kommunikationsstil. Experians Prognose „2026 Future of Fraud Forecast” identifiziert KI-gestützte, emotional intelligente Bots als eine der größten neuen Bedrohungen. Diese Bots passen Tonfall, Persönlichkeit und Gesprächsthemen an jedes Ziel an und lernen im Laufe der Zeit die Vorlieben ihrer Opfer kennen. Die Betrügereien eskalieren in der Regel von Dating-Plattformen zu privaten Nachrichten, in denen dann erfundene Finanzkrisen oder Investitions„möglichkeiten” vorgestellt werden. Die Opfer berichten von Interaktionen, die sich über monatelange Beziehungen hinweg sehr persönlich und authentisch anfühlten.

Was ist synthetischer Identitätsbetrug?

Bei synthetischem Identitätsbetrug werden mithilfe von KI fiktive Identitäten erstellt, indem reale Daten – wie beispielsweise gestohlene Sozialversicherungsnummern aus Datenlecks – mit erfundenen persönlichen Angaben wie KI-generierten Gesichtern, Adressen und Beschäftigungshistorien kombiniert werden. Im Gegensatz zum herkömmlichen Identitätsdiebstahl, bei dem ein Angreifer die Identität einer realen Person annimmt, repräsentieren synthetische Identitäten Personen, die nicht existieren, was die Aufdeckung erheblich erschwert. Group-IB berichtet, dass komplette synthetische Identitäts-Kits für etwa 5 US-Dollar erhältlich sind. Diese synthetischen Identitäten werden verwendet, um Bankkonten zu eröffnen, Kredite zu beantragen, Beschäftigungsnachweise zu erhalten und betrügerische Geschäftsbeziehungen aufzubauen. Finanzinstitute sind am stärksten gefährdet, aber jede Organisation, die bei der Kundenaufnahme auf Identitätsprüfungen angewiesen ist, ist einem Risiko ausgesetzt.

Kann KI gefälschte Websites erstellen?

Ja. KI kann überzeugende Website-Klone in großem Umfang generieren und dabei das Branding, den Inhalt und die Funktionalität legitimer Websites replizieren. Palo Alto Unit 42 dokumentierte das „Quantum AI”-Schema, bei dem Angreifer gefälschte Handelsplattformen mit KI-generierten Inhalten, gefälschten Leistungsdaten und synthetischen Kundenbewertungen erstellten. Die „Truman Show”-Operation von Check Point nutzte servergesteuerte mobile Apps, die in offiziellen App-Stores erhältlich waren. Experian prognostiziert, dass das Klonen von Websites in großem Maßstab zu den Top-Betrugsmethoden des Jahres 2026 gehören wird. Diese gefälschten Websites sind allein durch visuelle Überprüfung immer schwieriger von legitimen Plattformen zu unterscheiden. Unternehmen sollten auf die unbefugte Verwendung ihres Brandings und ihrer Domain-Varianten achten, während Nutzer die Legitimität einer Plattform über offizielle Kanäle überprüfen sollten, bevor sie Anmeldedaten oder Finanzinformationen eingeben.